《Multimodal Learning with Transformers: A Survey》

URL:https://arxiv.org/abs/2206.06488

单位:Tsinghua University & University of Surrey & University of Oxford

会议:TPAMI 2022

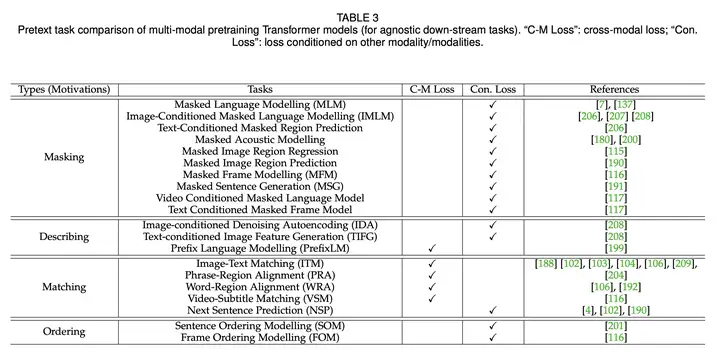

多模态 Transformer 的各种预训练代理任务如下图所示:

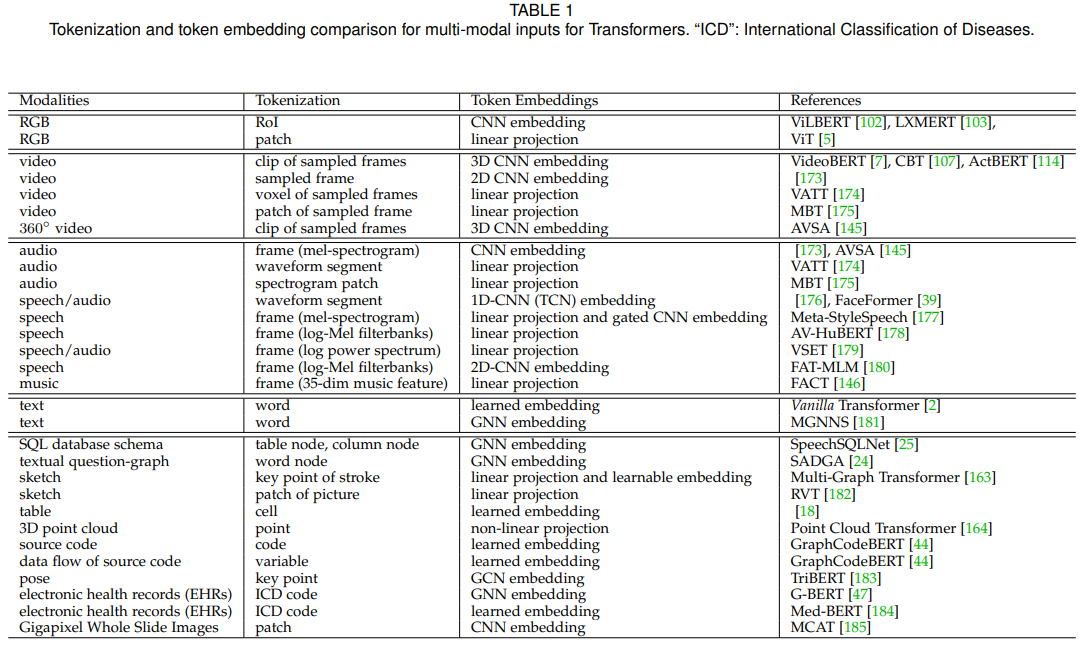

多模态 Transformer 对不同输入模态采取的 Tokenization 和 Token Embedding 方式如下图所示:

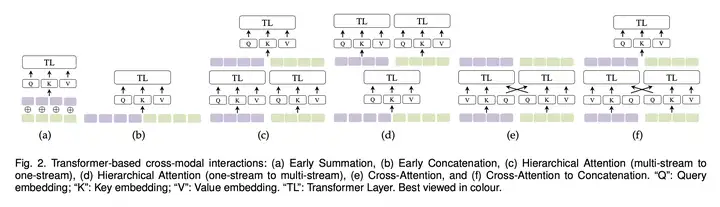

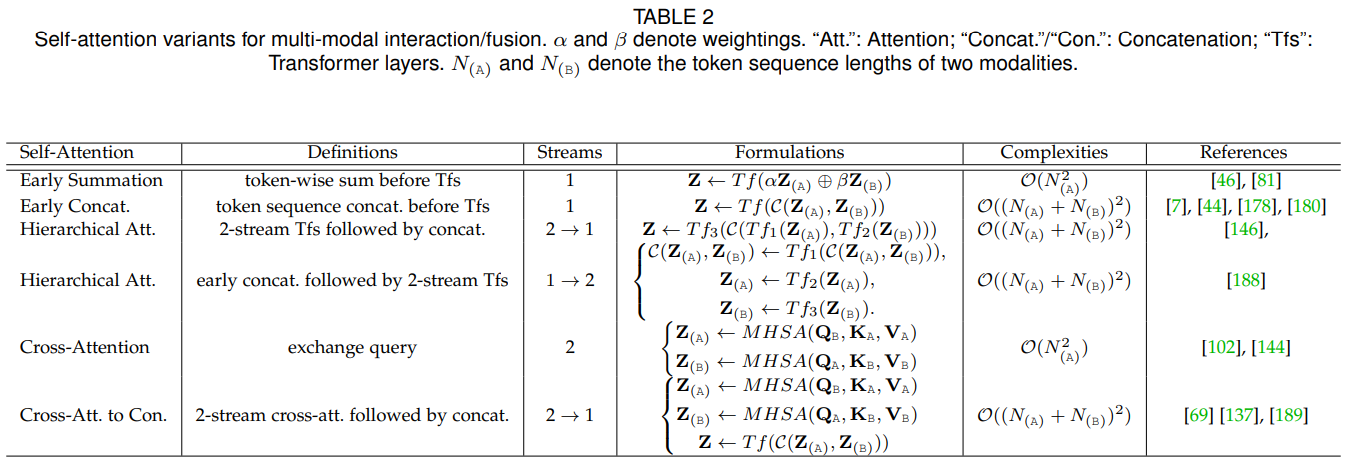

模态融合方式

参考

文档信息

- 本文作者:Bookstall

- 本文链接:https://bookstall.github.io/2023/05/28/multimodal-transformer-survey/

- 版权声明:自由转载-非商用-非衍生-保持署名(创意共享3.0许可证)